在本人工智能教程中,我们将学习:

“**环境**”这个词对每个人来说都很熟悉。根据牛津词典的定义:“*环境是人、动物或植物生活或操作的周围或条件。*”但在计算领域,它是计算设备工作或操作的周围环境。在人工智能的上下文中,环境简单来说就是代理的周围环境,也是代理操作的地方。要了解更多关于代理的信息,请访问我们之前的教程——AI 中的代理。

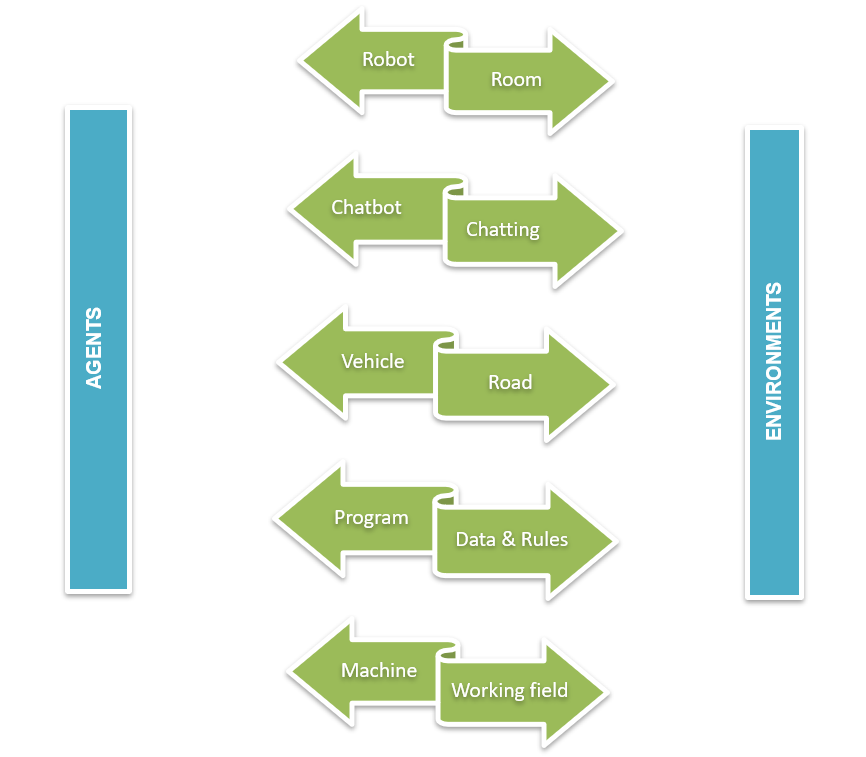

现在,让我们考虑一个在路上开车的真实示例。你能猜到谁是代理,谁是环境吗?是的,

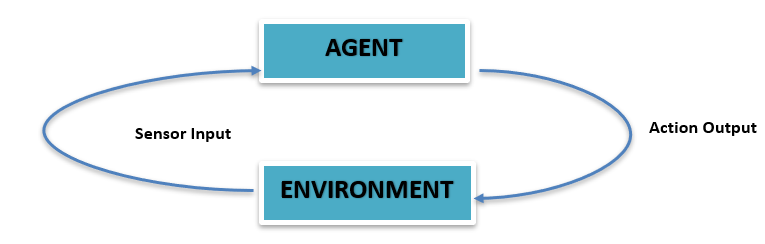

同样在人工智能中,我们有一个包含代理、传感器和执行器的环境。

上图显示了代理-环境交互的最简单示意图。代理位于环境中。有传感器感知环境,它们向代理提供感官输入。然后代理针对相应的输入采取行动,并将输出反馈给环境。

对于人工智能来说,需要解决的问题本身就带来了巨大的挑战。理解给定的问题本身就是人工智能的一项具有挑战性的任务。除了推理之外,人工智能问题中最具挑战性的方面是环境。

代理和环境可以说是人工智能所依赖的两个钩子。或者更简单地说,环境被认为是问题,那么代理就是问题的解决方案,或者“代理”是在“环境”这个地面上玩的游戏。

为了清楚理解,上面显示了一些代理及其环境的示例。对于给定的驾驶任务,车辆是代理,道路是驾驶环境。摄像头、雷达、激光雷达等传感器设备将收集有关道路的信息,例如行人的存在、道路上其他车辆的数量、交通信号等。然后车辆将根据这些信息采取行动,例如是否需要踩下刹车踏板或油门踏板,或者是否需要转弯等。

如果一台机器是一个代理,那么它的工作场所就是它的环境。如果我们将冷却系统视为代理,那么它所服务的行业就是环境。冷却液温度传感器将收集信息,机器将根据这些信息采取行动。

人工智能也可以称为对理性代理及其环境的研究。从这个陈述本身就可以清楚地看出代理和代理环境对人工智能的重要性。人工智能系统的工作可以用最少的词语来描述。通过不同类型的传感器,代理将感知环境,并通过执行器,代理将作用于其环境。代理环境的结构将影响整个人工智能系统本身。

代理对环境没有完全的控制权,但有部分控制权。这意味着环境受代理的影响。但代理的性能直接受环境变化的影响。即,代理在两种不同环境中执行相同任务将导致完全不同的结果。代理预先编程了一组能力,它可以在其环境中可能遇到的不同情况下应用这些能力。这些预编程的能力称为**效应器能力**。代理的传感器严格受环境影响。代理利用其效应器能力和传感器信息进行决策。并非所有行动都适合所有情况。先决条件必须适合执行特定任务。例如,代理必须开门,并且它能够这样做。但这只有在门未上锁(先决条件)的情况下才能执行。 因此,在给定情况下决定要执行的行动以实现目标或至少朝着目标努力是代理在环境中面临的最大问题。环境的属性直接影响决策过程中的复杂性。

人工智能中的代理环境分为不同的类型。环境根据代理如何处理它进行分类。

分类如下:

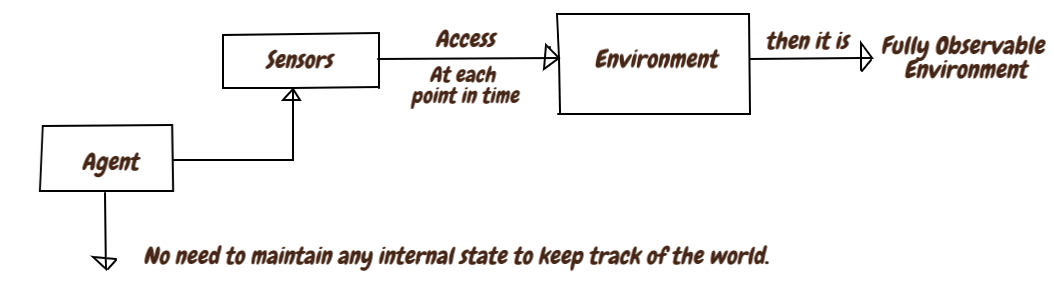

顾名思义,代理的环境始终被观察。在每个时间点,传感器都会感知或访问环境的完整状态。这种完全被观察的环境称为**完全可观察**,否则,如果它没有随时间变化而连续感知或观察,则称为**部分可观察**。任何时间都没有被任何传感器观察或访问的环境称为不可观察环境。由于不需要跟踪世界,完全可观察的环境更方便。

在现实生活中,**国际象棋**是完全可观察的一个例子,因为国际象棋的每个玩家都可以看到整个棋盘。完全可观察环境的另一个例子是道路,当汽车在道路(**环境**)上行驶时,驾驶员(**代理**)可以在给定时间看到道路上的所有交通信号、状况和行人,并据此驾驶。

**纸牌游戏**可以被视为部分可观察的示例。在这里,一些牌面朝下丢弃到一堆中。用户只能看到自己的牌。已用的牌、为将来保留的牌对用户是不可见的。

一个不受代理行动影响的环境称为静态环境。静态环境是最简单易处理的,因为代理在行动过程中无需跟踪世界。但如果环境因代理的行动而改变,则称其为动态环境。动态环境不断变化。一个随时间保持不变且代理的性能分数随时间变化的环境称为半动态环境。

填字游戏可以看作是静态环境的一个例子,因为填字游戏中的问题在开始时就已暂停。填字游戏的环境保持不变,环境不会扩大或缩小,它保持不变。

对于动态环境,我们可以将过山车骑行作为一个例子。环境在运动中不断变化。高度、质量、速度、不同的能量(动能、势能)、向心力等将随时间变化。

具有有限可能性的环境称为离散环境。对于离散环境,要达到最终目标需要执行有限数量的动作或感知。对于连续环境,感知的数量仍然未知且连续。

在国际象棋游戏中,每个棋子的可能移动是有限的。例如,国王只能向任何方向移动一个方格,直到该方格未被对手的棋子攻击。因此,特定棋子的可能移动是固定的,可以将其视为离散环境的示例,但每个游戏的移动次数会因游戏而异。

自动驾驶汽车是连续环境的一个例子。周围环境随时间变化,交通高峰、道路上其他车辆的速度等都会随时间连续变化。

忽略不确定性的环境称为确定性环境。对于确定性环境,即将到来的条件或状态可以通过环境的当前条件或状态以及代理的当前行动或代理选择的行动来确定。具有随机性的环境称为随机环境。即将到来的状态不能由当前状态或代理决定。大多数现实世界的人工智能应用都属于随机类型。环境只有在部分可观察时才是随机的。

对于棋盘上的每个棋子,它们当前的位置可以设定下一步的行动。不存在不确定性。一个棋子从当前位置可以采取的所有步骤都可以确定,因此,它可以归类为确定性环境。

但是对于自动驾驶汽车,未来的动作无法在当前状态下确定,因为环境不断变化。汽车可能需要踩刹车,或者可能需要完全踩油门,这取决于当时的环境。动作无法确定,是随机环境的一个例子。

仅包含单个代理的环境称为单代理环境。所有对环境的操作都由该代理执行和控制。如果环境包含一个以上代理或多个代理来执行操作,则此类环境称为多代理环境。

在真空吸尘器环境中,真空吸尘器是环境中唯一的代理。它可以被视为单代理环境的一个示例。

多代理系统,即具有多个交互代理的基于计算机的环境,是多代理环境的最佳示例。计算机游戏是常见的 MAS 应用。生物代理、机器人代理、计算代理、软件代理等是计算机游戏中共享环境的一些代理。

一系列动作的环境,其中代理的当前动作不会对未来的动作产生任何影响。它也称为非顺序环境/情景环境。顺序或非情景环境是指代理的当前动作会影响未来动作的环境。

对于分类任务,代理将根据时间从环境中接收信息,并且仅对这些信息执行动作。当前动作对未来动作没有任何影响,因此可以归类为情景环境。

但对于国际象棋游戏,特定棋子的当前动作会影响未来的动作。如果棋子现在向前迈一步,接下来的动作将取决于这一步的移动方向。这是顺序的。

已知与未知是代理的状态,而不是环境的属性。如果代理知道所有动作的所有可能结果,则它是已知环境。如果代理不知道动作的结果,并且需要学习环境才能做出决策,则称为未知环境。

如果代理的传感器可以完全访问环境的状态,或者代理可以访问有关环境状态的完整信息,则称为可访问环境。否则,它是不可访问的,或者代理无法完全访问环境状态。

| 任务环境 | 可观察的 | 确定 | 情景式 | 静态 | 离散的 | 代理 |

|---|---|---|---|---|---|---|

|

填字游戏 |

完全 |

确定 |

顺序 |

静态 |

离散的 |

单一 |

|

出租车驾驶 |

部分 |

随机 |

顺序 |

动态 |

连续 |

多 |

|

医学诊断 |

部分 |

随机 |

顺序 |

动态 |

连续 |

单一 |

|

图像分析 |

完全 |

确定性 |

情景式 |

半 |

连续 |

单一 |

代理与环境之间的交互是一个与时间相关的过程。在每个时间步,代理收集有关环境状态表示的信息。根据这些信息,代理将从该状态可用的动作中选择一个动作。在一个时间步之后,代理将收到一个数字奖励作为特定动作的结果,并进入一个新状态。这种交互是一个连续的过程,代理选择动作,环境将对这些动作做出响应,并向代理呈现新情况。

上图显示了典型的人工智能学习结构。

学习技术用于解决人工智能给定的任务。该图解释了代理如何与环境交互。当代理采取行动时,环境的状态会发生变化,并让代理了解变化并获得奖励。这一过程一直持续到达到目标。